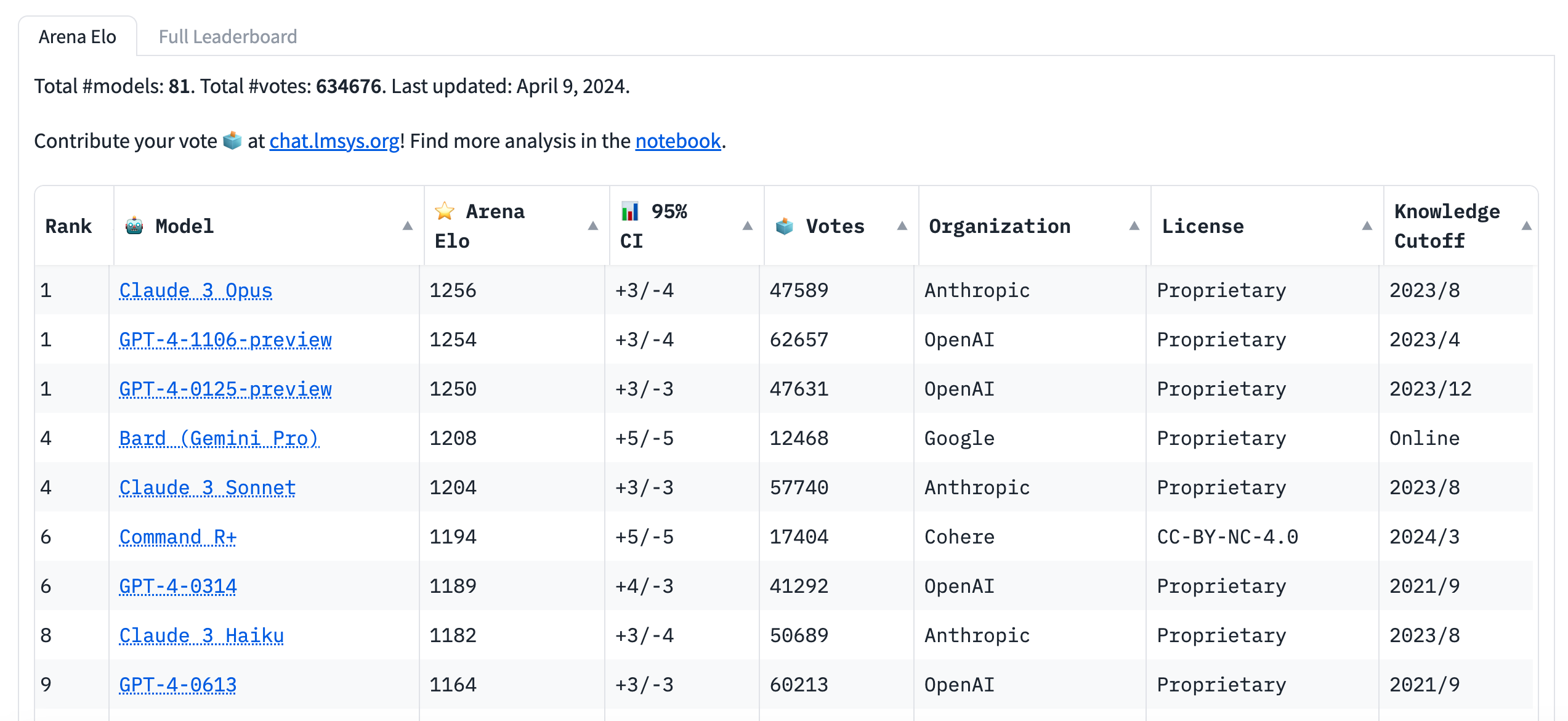

최근 출시된 클로드 3 오푸스(Claude 3 Opus)는 챗봇 아레나 리더보드에서 GPT-4를 제치고 1위를 차지했습니다. 이에 많은 기업들이 확장된 컨텍스트 윈도우 크기와 낮은 비용 등의 장점에 이끌려 클로드 모델을 자사 유스케이스에 적용하기 위해 평가하기 시작했습니다.

이 글에서는 여러가지 테스트 결과를 바탕으로 다양한 태스크에서의 GPT-4와 클로드 3 오푸스의 성능을 분석해보겠습니다. 두 모델의 비용, 컨텍스트 윈도우, 벤치마크 점수를 기본적으로 비교하고, 긴 컨텍스트 처리, 수학 문제, 문서 요약, 데이터 추출, 히트맵 해석, 코딩 등 4가지 태스크에서의 성능도 살펴보겠습니다.

클로드 3 오푸스 (Claude 3 Opus) vs GPT-4 비용 및 컨텍스트 윈도우 비교

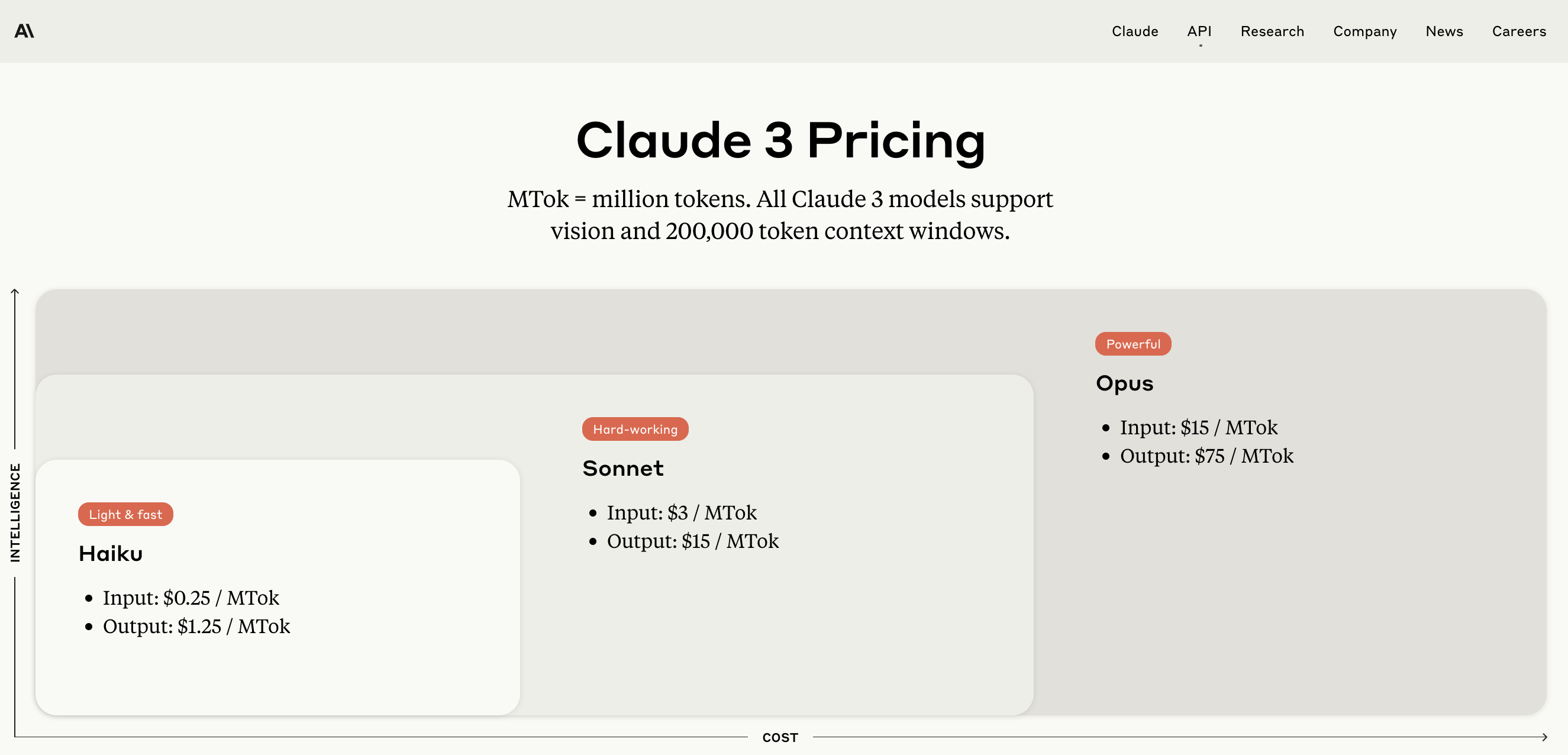

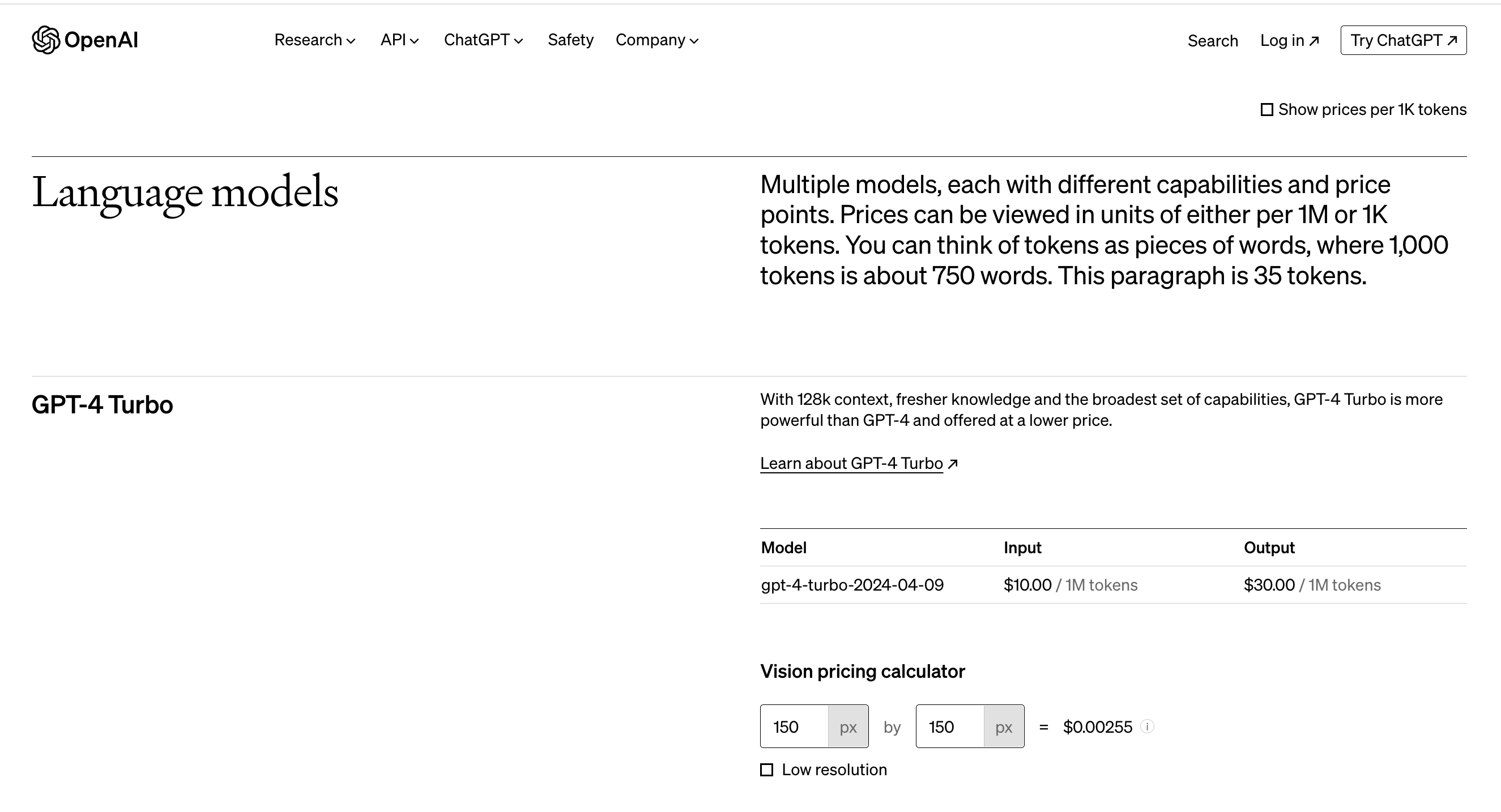

두 AI 모델은 고성능 모델에서 경쟁하며, 특히 복잡한 언어 이해 및 생성 작업에서 강점을 보입니다. 두 모델 모두 멀티모달 입력과 함수 호출을 지원하여 복잡한 애플리케이션에 유연성을 제공합니다. 다음은 각 모델의 주요 특징과 비용을 비교한 표입니다:

| 특성 | 클로드 3 오푸스 | GPT-4 Turbo |

|---|---|---|

| 입력 가격 | $15.00 / 1M 토큰 | $10.00 / 1M 토큰 |

| 출력 가격 | $75.00 / 1M 토크 | $30.00 / 1M 토큰 |

| 컨텍스트 윈도우 | 200K 토큰 | 128K 토큰 |

| 특징 | 비전 지원, 넓은 컨텍스트 윈도우 | 최신 지식, 넓은 기능 범위 |

종합해 보면, 클로드 3 오푸스는 비용 효율성과 큰 컨텍스트 윈도우라는 장점을 가지며, GPT-4는 특정 전문 태스크에서 우수할 수 있습니다. 프로젝트의 요구사항에 따라 적절한 모델을 선택하는 것이 중요합니다.

참고 정보

- 클로드 3 오푸스: 모든 클로드 3 모델은 비전을 지원하고 200,000 토큰의 컨텍스트 윈도우를 가집니다. Opus 모델은 입력 비용이 $15 / MTok, 출력 비용이 $75 / MTok 입니다.

- GPT-4 Turbo: 128K 컨텍스트 윈도우를 지원하며, 최신 지식과 가장 넓은 기능 범위를 갖춘 모델로서 비용 대비 더 강력한 성능을 제공합니다.

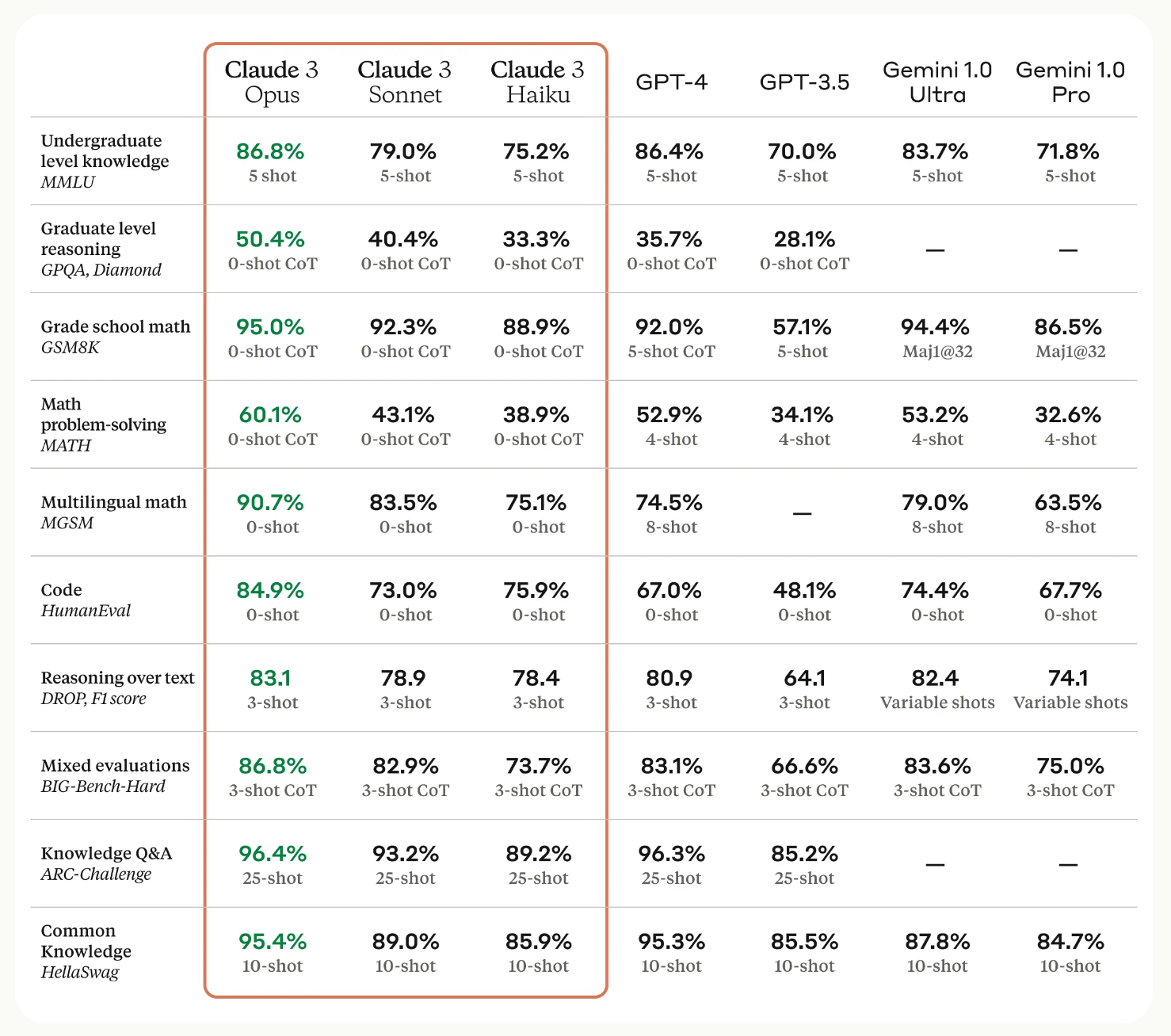

표준 벤치마크 비교

Anthropic의 기술 보고서에 따르면 모든 클로드 3 모델이 새로운 성능 기준을 세웠다고 합니다. 아래 이미지는 GPT-3.5, GPT-4 대비 클로드 3 모델들의 성능을 보여줍니다.

이 결과는 클로드 3 오푸스와 소넷이 GPT-4 터보와 GPT3.5에 대한 강력한 도전자가 되었음을 시사합니다.

하지만 벤치마크 결과에 대해서는 주의 깊게 살펴볼 필요가 있습니다. 일부 연구자들은 최신 GPT-4 모델이나 다른 벤치마킹 기법으로 클로드 3와 비슷하거나 더 높은 점수를 얻었다고 주장하기도 합니다.

벤치마크 결과를 해석할 때는 디테일에 주목해야 합니다. 우리가 실제 사용하는 태스크에 맞춰 내부 벤치마크를 수행해보는 것이 중요합니다.

한 가지 분명한 것은 클로드 3 모델이 강력하고 GPT-4의 경쟁자로 부상했다는 점입니다.

클로드 3 오푸스 vs GPT-4 모델 성능 비교

태스크 1: 긴 컨텍스트 처리

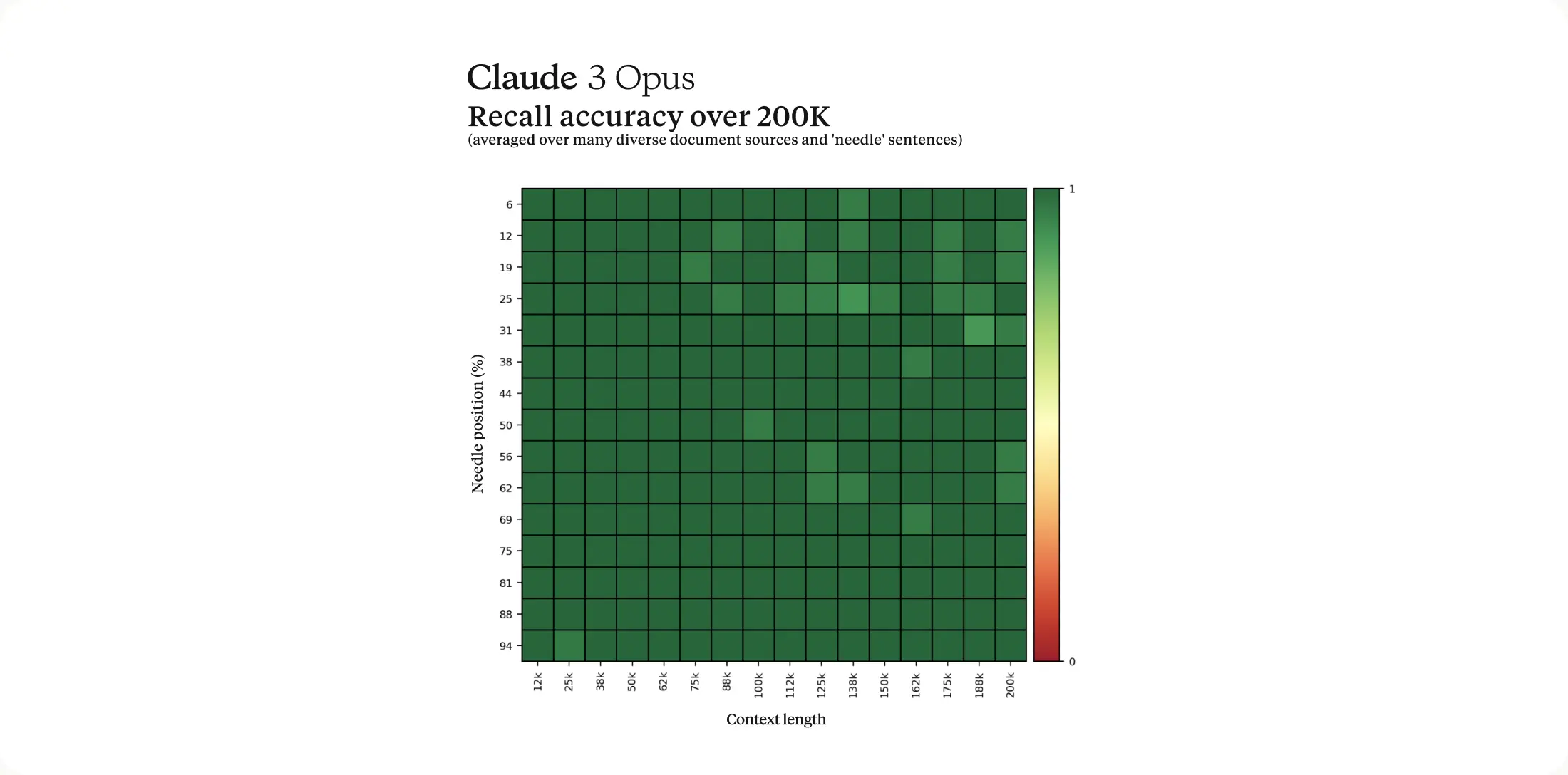

긴 컨텍스트 프롬프트를 효과적으로 처리하기 위해서는 모델이 강력한 리콜(회상) 능력을 가져야 합니다. '니들 인 어 헤이스택'(NIAH, 바늘을 건초더미에서 찾기) 평가는 모델이 방대한 데이터 집합에서 정보를 정확하게 회상해내는 능력을 측정합니다. 이 벤치마크의 강도를 높이기 위해, 우리는 프롬프트당 30개의 무작위 질문/답변 쌍 중 하나를 사용하고 다양한 크라우드소싱 문서 집합에서 테스트를 진행했습니다. Claude 3 Opus는 99% 이상의 정확도를 넘어서며 거의 완벽한 리콜을 달성했을 뿐만 아니라, 일부 경우에는 평가 자체의 한계를 식별하기도 했습니다. 즉, '니들' 문장이 사람에 의해 원본 텍스트에 인위적으로 삽입된 것으로 보인다는 사실을 인식했습니다.

- '리콜'이란 기억에서 정보를 꺼내오는 능력을 말합니다. AI 분야에서 리콜은 모델이 주어진 정보 또는 데이터 집합에서 필요한 정보를 정확하게 "회상"하여 제공하는 능력을 의미합니다. 예를 들어, 방대한 데이터베이스에서 특정 정보를 찾아내는 것과 같이, 모델이 과거에 접근했던 정보를 정확히 다시 불러오는 것을 말합니다. Claude 3 Opus의 경우, 이는 매우 큰 데이터 집합에서 필요한 정보를 정확하게 찾아낼 수 있음을 의미하며, 이는 특히 정보가 많은 상황에서 매우 유용합니다.

Anthropic의 자체 연구에 따르면 오푸스는 99% 이상의 정확도로 거의 완벽한 리콜을 달성했고, 심지어 평가 자체의 한계(즉, "바늘" 문장이 인위적으로 삽입된 것처럼 보인다는 점)를 인식하기도 했습니다.

이러한 테스트 결과는 오푸스가 긴 컨텍스트 처리에서 GPT-4보다 우수함을 시사합니다.

태스크 2: 문서 요약

오푸스는 보고서 결과를 언급하지 않고 높은 수준에서 요약한 반면, GPT-4는 결과를 포함하면서 약간 더 긴 요약을 제공했습니다.

오푸스의 간결�한 요약이 빠른 인사이트를 원하는 사람들에게 어필할 수 있겠지만, 어떤 이들은 GPT-4처럼 문서의 뉘앙스를 파고드는 상세한 분석을 선호할 수도 있겠네요. 간결함과 디테일 중 무엇을 선택할지는 개인이나 조직의 필요에 달려 있습니다.

태스크 3: PDF 데이터 추출

PDF 주문서에서 주문 데이터를 추출하도록 요청했을 때, 오푸스는 처음에 어떤 값도 추출하지 못했습니다. PDF 파일에 문제가 있을 수 있다고 생각해 편집기에서 업데이트하고 저장해봤지만 소용없었죠.

그러다 PDF 스크린샷을 찍어주니 오푸스가 성공적으로 데이터를 추출할 수 있었습니다. 반면 GPT-4는 모든 테스트에서 PDF에서 데이터를 잘 추출했습니다.

이 사례는 더 조사가 필요해 보이지만 오푸스의 가격과 GPT-4의 성공 경험을 고려하면 이런 유스케이스에서는 GPT-4를 계속 사용하는 것이 나을 수 있을거 같습니다.

태스크 4: 코딩

여러 기사들을 살펴본 결과, 오푸스가 프로그래밍과 코딩 태스크의 특정 측면에서 GPT-4를 능가하는 것으로 보입니다. 전반적인 긍정적인 평가들도 GPT-4보다 오푸스에 더 쏠려 있습니다.

주요 발견 사항은 다음과 같습니다:

- 오푸스는 Aider의 코드 편집 벤치마크에서 사상 최고 점수를 기록했습니다. 2번의 시도로 68.4%의 태스크를 완료했죠. 이는 54.1%를 기록한 최신 GPT-4 모델보다 우수한 성적입니다.

- 사용자들은 GPT-4와 비교할 때 오푸스가 "훨씬 더 요점을 짚고, 완전히 새로운 솔루션을 제안하기보다는 더 '기꺼이' 하는 것 같다"고 보고합니다.

- 오푸스는 문서를 정리하고 분석을 생성하는 태스크에서 GPT-4보다 더 집중적이고 실행 가능한 응답을 제공하는 데 뛰어납니다. GPT-4는 무관한 아이디어가 더 많았죠.

- 오푸스는 더 큰 컨텍스트 윈도우를 가지고 있어 대규모 코드베이스 작업 시 유리할 수 있습니다.

다만 클로드 3 오푸스에는 다음과 같은 한계도 보고되었습니다:

- GPT-4와 달리 특정 코딩 태스크를 수행할 수 없어 오류를 반환하는 경우가 있습니다.

- 복잡한 논리 추론과 수학 문제에서는 GPT-4가 여전히 오푸스보다 약간 앞설 수 있습니다.

요약하자면 오푸스가 많은 코딩과 프로그래밍 태스크, 특히 집중적이고 실행 가능한 응답 제공 측면에서 GPT-4를 능가하는 것으로 보입니다. 하지만 논리 추론 태스크 같은 특정 영역에서는 GPT-4가 여전히 우위에 있을 수 있죠.

결국 두 모델 중 어떤 것을 선택할지는 프로그래밍 태스크의 구체적인 요구사항과 가격에 달려 있을 것 같네요.

지금 까지 클로드 3 오푸스와 GPT-4의 여러 태스크에서의 성능을 비교해보았습니다. 두 모델의 장단점을 고려해 자신의 유스케이스에 맞는 모델을 선택하는 것이 중요합니다. 상황에 맞는 모델을 선택해 더 나은 결과를 얻길 바랍니다.